Durante la conferencia Build 2020, Microsoft descubrió AI at Scale. Se trata de una iniciativa destinada a aplicar inteligencia artificial a gran escala. También supercomputación al procesamiento del lenguaje en aplicaciones, servicios y productos administrados de la compañía. Con esto, Los motores de búsqueda aprovechan la IA para mejorar su comprensión del idioma.

Microsoft dice que los algoritmos masivos han impulsado mejoras en SharePoint, OneDrive, Outlook, Xbox Live y Excel. También han beneficiado a Bing, al refozar la capacidad del motor de búsqueda para responder preguntas directamente y generar subtítulos de imágenes.

Los motores de búsqueda aprovechan la IA para mejorar su comprensión del idioma

Bing y sus competidores tienen mucho que ganar con la IA y el ML, particularmente el dominio del lenguaje natural. Las tareas de búsqueda comienzan necesariamente con descifrar la intención de u na búsqueda. Los motores de búsqueda deben comprender las consultas, sin importar cuán confusas o erróneas estén redactadas. Históricamente han luchado contra esto, apoyándose en palabras simples como «y», «o» y «no». Pero con el advenimiento de la inteligencia artificial como BERT de Google y la familia Turing de Microsoft, los motores de búsqueda tienen el potencial de ser más conscientes de la conversación y del contexto que nunca.

Modelos de lenguaje a gran escala

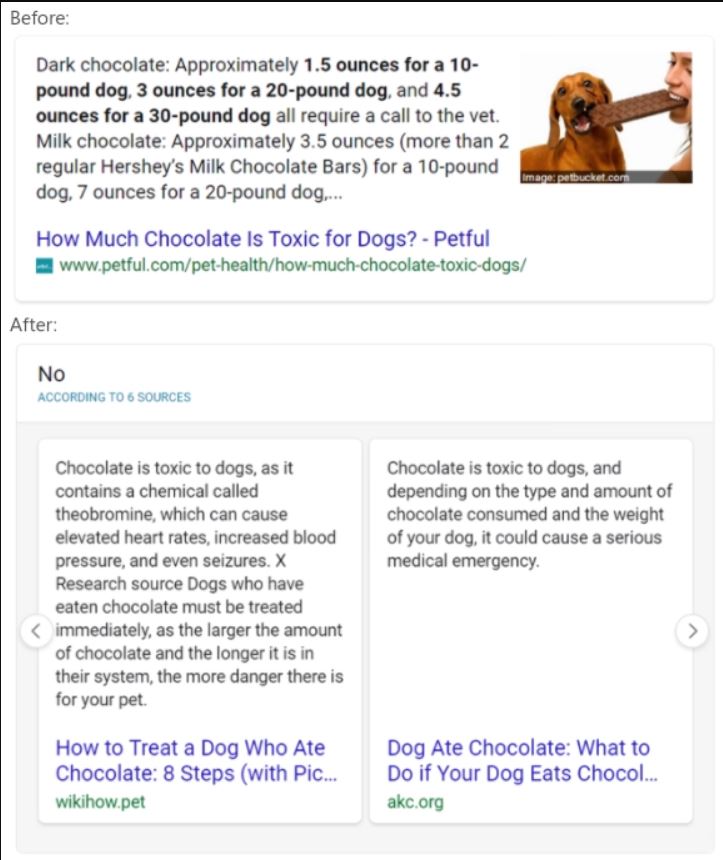

Bing ahora usa modelos de lenguaje ajustados a partir de un algoritmo de representación de lenguaje natural multimodal a gran escala. Con esto se potencian una serie de características, incluidos resúmenes inteligentes de sí/no. Dada una consulta de búsqueda, un modelo evalúa la relevancia de los pasajes de documentos en relación con la consulta y razona y resume a través de múltiples fuentes para llegar a una respuesta. Una búsqueda de «¿pueden los perros comer chocolate?» provocaría que el modelo, que puede entender el lenguaje natural gracias a la NLR, deduzca que esa frase significa que los perros no deberían comer chocolate, incluso cuando una fuente no lo diga expresamente.

Más allá de esto, basándose en un algoritmo basado a su vez en NLR de Turing recientemente implementado y que mejoró las respuestas y descripciones de imágenes, el equipo de Bing usó el componente de preguntas y respuestas del algoritmo para mejorar la calidad de la respuesta «inteligente» en otros idiomas. Afinado solo con datos en inglés, el componente se basó en el conocimiento lingüístico y los matices aprendidos por el algoritmo NLR, que se entrenó previamente en 100 idiomas distintos. Esto le permitió devolver fragmentos de respuesta idénticos en todos los idiomas en 13 mercados.

El equipo de Bing también aplicó IA al problema fundamental de romper conceptos ambiguos. Un nuevo algoritmo organizado por NLR diseñado para clasificar los posibles resultados web para consultas usa la misma escala que los jueces humanos. Esto permite darse cuenta de que la búsqueda «cervecería Alemania del año 1080», probablemente se refiere a la cervecería Weihenstephan, por ejemplo, fundada 40 años antes (1040), pero en el mismo período de tiempo.

Hardware

Los modelos a gran escala como los que ahora impulsan Bing aprenden a analizar el lenguaje a partir de enormes conjuntos de datos. Por ejemplo, el más grande de los modelos Turing de Microsoft, Turing Natural Lenguage Generation, ingirió miles de millones de páginas de texto de libros autoeditados, manuales de instrucciones, lecciones de historia y otras fuentes para lograr los mejores resultados en puntos de referencia del lenguaje popular.

Como es de esperar, los modelos grandes requieren hardware escalable para que coincidan. Microsoft dice que está ejecutado el modelo Bing derivado de NLR para la comprensión de la intención de consulta en las máquinas virtuales de la serie N de Azure. En cuatro regiones a partir de noviembre de 2019, más de 2.000 de estas máquinas estaban sirviendo más de 1 millón de inferencias de búsquedas por segundo en cuatro regiones.

Suponemos que la tendencia del procesamiento del lenguaje natural a gran escala se mantendrá. Los modelos como los de la familia Turing de Microsoft parecen estar listos para convertirse en una parte central de los motores de búsqueda.