La batalla por ofrecer la mejor I.A no ha hecho más que comenzar, y es que existen varias empresas con departamentos dedicados al desarrollo de hardware para potenciar las nueva I.A, que tanto están sorprendiendo ahora. De hecho, Google afirma que sus chips más recientes para entrenar modelos de I.A son mejores y más potentes que los de Nvidia, y se han utilizado para entrenar sus grandes modelos lingüísticos en un superordenador.

Más potentes y eficientes

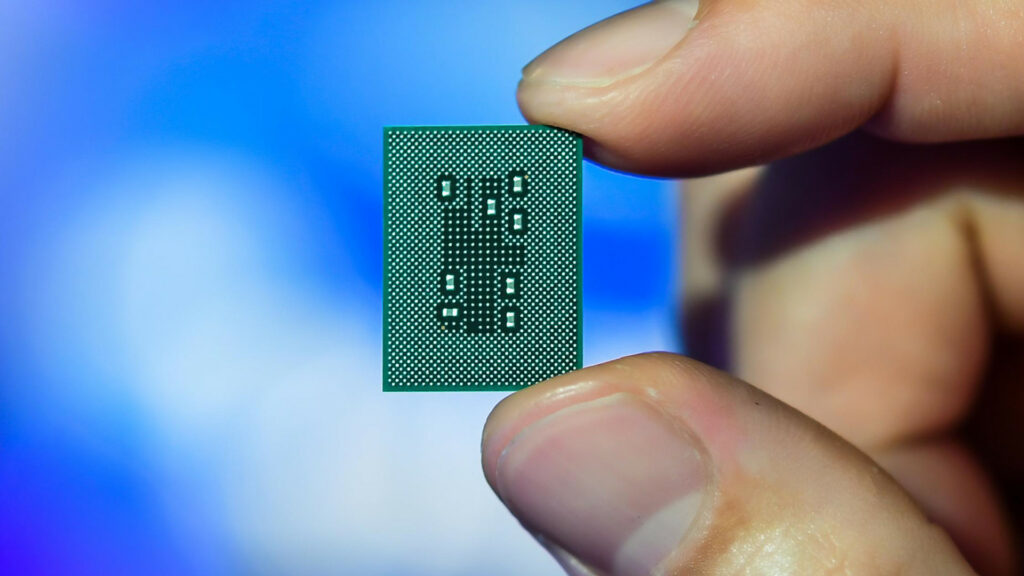

Su unidad de procesamiento tensorial (TPU) de 4ª generación está mejor equipada para el entrenamiento de I.A que sus predecesoras, y ofrece una mejora de velocidad 1,7 veces superior a la GPU competidora de Nvidia, la A100, según afirma la empresa.

Google describió los detalles técnicos de TPU v4 en un documento de investigación publicado el martes pasado. En él se afirmaba que el chip constituía la base de su tercer superordenador destinado específicamente a modelos de aprendizaje automático (ML), que contiene 4.096 TPU para multiplicar por diez la potencia total de los clusters anteriores.

Los chips de alto rendimiento como la TPU son componentes necesarios para los superordenadores, que en estos momentos se están utilizando especialmente como hardware para entrenar grandes modelos de lenguaje (LLM) para I.A generativa.

Google entrenó su propio LLM PaLM de 540.000 millones de parámetros utilizando dos clústeres de superordenadores TPU v4, que constituyen en parte la base de Bard, su respuesta a ChatGPT.

Consumo y costes de energía

En medio de la actual volatilidad de los precios de la energía, los centros de datos podrían enfrentarse a aumentos de costes de hasta el 40%, e incluso el riesgo de producirse apagones a corto y medio plazo.

Y es que no sólo de potencia vive el hombre, ya que la eficiencia es también fundamental para optimizar costes. El mes pasado, Google también anunció que el programa de generación de imágenes de I.A Midjourney se había entrenado utilizando TPU de Google, VM de GPU e infraestructura de Google Cloud.

La TPU también consume entre 1,3 y 1,9 veces menos energía que los chips A100 de Nvidia, un dato crucial para mantener bajos los costes energéticos y los presupuestos de carbono de los centros de energía y los superordenadores.

Los TPU de Google se utilizan en todos los centros de datos de Google Cloud, y la empresa declaró que los chips de 4ª generación de los ordenadores de almacén de Google Cloud consumen tres veces menos energía y producen 20 veces menos emisiones de CO2 que los centros de datos actuales.

Estas razones y otras mencionadas anteriormente dan una clara ventaja a Google, que afirma que sus chips son mejores que los de nVidia y la competencia. Todos estos detalles hacen a la TPU v4 de Google Cloud una propuesta atractiva para las empresas que buscan entrenar la I.A con un impacto mínimo de carbono.

nVidia no se queda dormida

Sin embargo, el documento no menciona el H100 de Nvidia, el nuevo acelerador de I.A de la empresa anunciado en marzo de 2022.

Nvidia ha declarado que el H100 ofrece un rendimiento 6,7 veces superior al de sus predecesores en las pruebas de ML, mientras que el A100 ofrece un rendimiento 2,5 veces superior en las mismas mediciones.

Es más, las grandes tecnológicas han acudido en masa a Nvidia en busca de hardware de I.A, y el gigante de las GPU incluso ha anunciado que su servicio de superordenadores DGX Cloud pronto estará disponible a través de Google Cloud.

En el mercado actual, sigue siendo una de las opciones más fiables en cuanto a hardware potente y energéticamente eficiente para I.A. No por nada proporcionó los chips para el superordenador de Microsoft utilizado para entrenar el modelo GPT-4 de OpenAI.